Régression bornée

La régression linéaire est une des méthodes statistiques les plus utilisées parce qu’elle donne des réponses à des questions que les spécialistes se posent fréquemment. Cette méthode est relativement puissante, mais les résultats qu’elle produit doivent être interprétés avec prudence et ne donnent pas plus de certitude que toute autre méthode statistique.

Dans cette application pédagogique, nous précisons une autre façon d’estimer les coefficients de régression et montrons par des simulations que cette nouvelle démarche donne des résultats bien meilleurs que ceux de la régression linéaire classique très instables dans certains cas.

I. Colinéarité et modèle linéaire.

1.1 Estimateurs dans le modèle linéaire

Le modèle linéaire consiste à représenter une relation entre une variable expliquée (ou dépendante) notée Y, et p variables explicatives (ou indépendantes) X1, X2, …, Xp par l’équation ci-dessous :

Y = b0 + b1 X1 + b2 X2 + … + bj Xj + ... + bp Xp + e

dans laquelle :

·

les coefficients bj,

j = 1, …p, sont des paramètres théoriques appelés coefficients de

régression ;

·

la variable e

est une variable aléatoire appelée variable résiduelle, centrée et de variance s

2 appelée variance résiduelle,

indépendante des variables explicatives ;

·

on suppose fréquemment que la

variable e suit la loi normale N(0,s).

L’estimateur B des moindres carrés ordinaires du vecteur b = (b1, …, bp)t est égal à :

|

|

s 2 |

|

|

B= |

___

|

R-1

Xt Y |

|

|

n |

|

la matrice R étant la matrice de corrélation entre les p variables explicatives, la matrice X contenant les observations xi,j (i = 1, …, n et j = 1,…, p) des variables Xj et la matrice colonne Y les observations yi (i = 1, …n) de la variable Y. On note b = (b1, …, bp)t l’observation du vecteur B et b0 l’estimation de b0 déduite des moyennes observées des variables Y et Xj, j = 1, …, p. Sa matrice variance B est donnée par :

|

|

s

2 |

|

|

VB= |

___ |

R-1 |

|

|

n |

|

Le coefficient de détermination noté R2 est le carré du coefficient de corrélation entre les valeurs observées yi, i = 1, …, n et les valeurs estimées par le modèle yi’ :

yi’

= b0 + b1 xi1 + …

+ bj xi,j + ... + bp xi,p

Les résidus ei (i = 1, …, n) sont les différences entre les valeurs observées de Y et les valeurs estimées :

|

" i = 1, …, n |

ei = yi – yi’ |

L’estimation sans biais de la variance résiduelle s 2 est donnée par :

|

|

1 |

n |

|

|

S’ 2 = |

_________ |

S |

ei 2 |

|

|

n

– p – 1 |

i

= 1 |

|

L’estimateur des moindres carrés B est efficace (de variance minimale dans la classe des estimateurs sans biais). Cette propriété a pour conséquences les propriétés suivantes :

· les résidus sont centrés ;

· les résidus et les valeurs estimées sont non corrélés.

1.2 Colinéarité et estimateur borné.

Les effets de la colinéarité entre les variables explicatives résultent de l’inversion de la matrice R des corrélations entre les variables explicatives dans le calcul de l’estimateur B et de sa matrice variance VB. La colinéarité crée tout d’abord une grande instabilité des estimations des coefficients de régression : les variances des estimateurs, proportionnelles aux termes diagonaux de R-1, sont particulièrement élevées. Les signes des coefficients estimés peuvent même être contraires à ceux des vraies valeurs. Le coefficient de détermination R2 peut aussi devenir très instable. L’interprétation des résultats est finalement sujette à caution.

Il n’est pas toujours facile de détecter cette colinéarité par une simple lecture de la matrice R (Foucart, 2000). On la recherche en examinant les valeurs propres de la matrice R et des indices comme les facteurs d’inflation, l’indice de conditionnement et de multicolinéarité : une petite valeur propre et des indices élevés indiquent une colinéarité statistique. On pourra sur ces points consulter l’ouvrage de Tomassone « La régression » (Masson, 1992).

Les procédures de simulation utilisée ci-dessous visualisent dans un premier temps ces propriétés connues au plan mathématique. Elles montrent aussi que la régression bornée (ou ridge regression) proposée par Hoerl et Kennard (1970) donne de bien meilleurs résultats que la régression des moindres carrés ordinaires dans le cas de données statistiquement colinéaires.

L’idée générale est la suivante : un estimateur efficace X d’un paramètre réel m est un estimateur de variance minimale dans la classe des estimateurs sans biais (E(X) = m), mais il ne minimise pas l’erreur quadratique définie par E(ïïX’ – mïï 2), dans laquelle X’ est un estimateur quelconque de m.

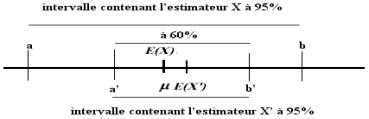

Nous avons représenté en figure 1 ci-dessous les intervalles [a, b] et [a’, b’] symétriques de centres E(X) et E(X’) tels que :

|

P( XÎ [a, b] )

= 0.95 |

P( X’Î [a’, b’] ) = 0.95 |

La valeur

m n’est pas au centre de l’intervalle de variation [a’,

b’] de X’ : cela signifie que X’ est biaisé. Inversement,

l’estimateur X est sans biais : m est au centre son

intervalle de variation [a, b], mais ce dernier est plus grand que le

précédent.

La valeur observée de X appartient à l’intervalle [a’, b’] dans 60% des cas, et la valeur observée de X’ dans 95% des cas : l’estimateur X’ est « plus souvent » près de la vraie valeur m que l’estimateur efficace X.

Figure 1 : intervalles de variation à 95%

de l’estimateur efficace X et d’un estimateur quelconque X’

Cette situation se présente dans le cas du modèle linéaire lorsque les variables explicatives sont statistiquement colinéaires. Nous allons vérifier par simulation que l’estimateur Br = (Br1, Br2, …, Brp)t obtenu par la régression bornée donne alors de meilleures estimations que l’estimateur efficace B = (B1, B2, …, Bp)t obtenu suivant le critère des moindres carrés ordinaires. L’estimateur Br est obtenu suivant le critère des moindres carrés et sous contrainte de norme :

ïBr÷ï

2 = br1 2 + br2 2 + ¼brp

2 £

M

En fait, ce n’est pas le majorant M que l’on fixe : on montre en effet qu’il suffit de remplacer dans la formule de l’estimateur des moindres carrés ordinaires la matrice R par la matrice R + k I, où I est la matrice identique et k une constante, pour modifier la norme de l’estimateur Br. En pratique, on recherche la meilleure constante k à l’aide de la représentation graphique des coefficients de régression en fonction de k, appelée ridge trace. Les formules concernant l’estimateur borné sont les suivantes :

|

|

s 2 |

|

|

s 2 |

|

|

Br= |

___ |

[R + k I]-1 Xt Y |

VBr= |

___ |

[R + k I]-1 |

|

|

n |

|

|

n |

|

II. Deux exemples.

2.1 Colinéarité et matrice de corrélation

Les quatre variables X1, X2, X3 et X4 dont les coefficients de corrélation sont donnés ci-dessous sont statistiquement colinéaires :

|

|

X1 |

X2 |

X3 |

X4 |

|

X1 |

1.000 |

|

|

|

|

X2 |

0.500 |

1.000 |

|

|

|

X3 |

0.500 |

0.500 |

1.000 |

|

|

X4 |

-0.500 |

0.400 |

0.300 |

1.000 |

Tableau

1 : matrice de corrélation des variables explicatives

Cette colinéarité peut être mise en évidence de plusieurs façons :

· le coefficient de détermination Rj 2 de chaque variable Xj par les autres est proche de 1. Les facteurs d’inflation fj sont élevés :

|

R1

2 = 0.984 |

R2

2 = 0.962 |

R3

2 = 0.929 |

R4

2 = 0.980 |

|

f1

= 1/(1-R1 2) = 62 |

f2

= 1/(1-R2 2) = 26 |

f3

= 1/(1-R3 2) = 14 |

f4

= 1/(1-R4 2) = 50 |

Tableau

2 : Coefficients de détermination et facteurs d’inflation

· l’indice de multicolinéarité, égal à la moyenne des facteurs d’inflation, est élevé :

|

I = 38 |

En l’absence de toute colinéarité, l’indice de multicolinéarité est égal à 1.

· il existe une valeur propre très faible :

|

l1

= 2.019 |

l2

= 1.47 |

l3

= 0.5 |

l4

= 0.007 |

La combinaison linéaire des variables X1, X2, X3 et X4 définie par la quatrième composante principale est donc presque constante et égale à 0.

· On utilise souvent l’indice de conditionnement, dont on trouvera une analyse dans Belsley (1980) :

|

k

= 1 / l4 = 148.83 |

L’analyse numérique de cette matrice (Foucart, 1997) montre aussi que le coefficient de corrélation r2,3 appartient nécessairement à l’intervalle ]0.472, 0.981[, les autres coefficients étant fixés. Il est significatif pour une taille suffisante de l’échantillon considéré : il y a alors transitivité de la corrélation.

Nous allons étudier à l’aide de simulations les résultats de la régression linéaire d’une variable Y par les quatre variables X1, X2, X3 et X4 .

2.2 Effet de la colinéarité sur les coefficients de régression estimés.

Les données[1] ridge1 contiennent les observations de cinq variables sur cent individus statistiques obtenues par simulation. On veut expliquer la cinquième variable, Y, par les quatre premières X1, X2, X3 et X4, dont la matrice de corrélation est égale à la précédente. Les variables explicatives sont centrées et réduites. Les coefficients de corrélation observés entre les variables explicatives et la variable expliquée sont donnés dans le tableau ci-dessous :

|

|

X1 |

X2 |

X3 |

X4 |

|

Y |

0.540 |

0.216 |

-0.107 |

-0.491 |

Tableau

3 : coefficients de corrélation observés entre Y et X1, X2,

X3 et X4 (données ridge1)

La régression des moindres carrés ordinaires donne les résultats suivants :

|

degré

de liberté |

Somme

des carrés |

Variance

estimée |

Pourcentage

de variance totale |

|

Tot 99 |

229.7305 |

2.320510 |

1 |

|

Exp 4 |

112.7185 |

1.088805 |

0.490655 |

|

Res 95 |

117.0120 |

1.231705 |

0.509345 |

Tableau 4 : analyse de variance (données ridge1, n =

100)

|

|

Estimation |

écart-type |

t de Student |

facteur

d’inflation |

|

b1 |

1.6339 |

0.8739 |

1.870 |

62.00 |

|

b2 |

-0.1482 |

0.5659 |

-0.262 |

26.00 |

|

b3 |

-1.0375 |

0.4153 |

-2.498 |

14.00 |

|

b4 |

0.4439 |

0.7848 |

0.566 |

50.00 |

|

Cst |

-0.1650 |

0.1110 |

-1.486 |

|

Tableau

5 : estimation des coefficients de régression (données ridge1)

Les variables explicatives étant réduites et l’écart-type de la variable expliquée égal à 1.516, on peut apprécier intuitivement la taille des coefficients de régression. Les coefficients de régression b1, b3 prennent des valeurs élevées en valeur absolue. Le coefficient de régression b2 est négatif, malgré un coefficient de corrélation positif entre X2 et Y (0.216), et b4 est positif malgré un coefficient de corrélation entre X4 et Y fortement négatif (-0.491). Seul b3 est significativement non nul pour un risque de première espèce a = 5% (t = -2.498). Le coefficient de détermination (R2 = 0.49) est hautement significatif.

Ces résultats peuvent s’expliquer par la forte colinéarité statistique entre X1, X2, X3, et X4, caractérisée dans le tableau 5 par la valeur élevée des facteurs d’inflation, qui perturbe les estimations des coefficients de régression et leurs variances.

2.3 Effet de la colinéarité sur les variances.

On étudie maintenant les données ridge2, obtenues par simulation suivant le même modèle que précédemment. La matrice de corrélation entre les variables explicatives est égale à R, les coefficients de régression théoriques sont les mêmes, mais les corrélations observées entre la variable expliquée et les variables explicatives sont les suivantes :

|

|

X1 |

X2 |

X3 |

X4 |

|

Y |

0.486 |

0.084 |

-0.199 |

-0.584 |

Tableau 6 : coefficients de corrélation entre Y et X1,

X2, X3 et X4 (données ridge2)

La régression des moindres carrés ordinaires donne les résultats ci-dessous :

|

degré de liberté |

Somme des carrés |

Variance estimée |

Pourcentage de variance totale |

|

Tot 99 |

188.1299 |

1.900302 |

1 |

|

Exp 4 |

94.14017 |

0.9109364 |

0.500400 |

|

Res 95 |

93.98971 |

0.9893653 |

0.499600 |

Tableau

7 : analyse de variance (données ridge2, n = 100)

|

|

Estimation |

écart-type |

t de Student |

facteur

d’inflation |

|

b1 |

0.4638 |

0.7832 |

0.592 |

62.00 |

|

b2 |

0.3674 |

0.5072 |

0.724 |

26.00 |

|

b3 |

-0.5204 |

0.3722 |

-1.398 |

14.00 |

|

b4 |

-0.5594 |

0.7033 |

-0.795 |

50.00 |

|

Cst |

-0.0985 |

0.0995 |

-0.990 |

|

Tableau

8 : estimation des coefficients de régression (données ridge2)

La situation est paradoxale : le coefficient de détermination R2 est hautement significatif (R2= 0.50, n = 100), mais aucun des coefficients de régression ne peut être considéré comme non nul. On peut apporter comme explication une surestimation des écarts-types des estimateurs Bj. Les estimations b1, b2, b3 et b4 ne paraissent pas en effet spécialement grandes (les variables explicatives sont réduites, et l’écart-type de la variable expliquée est égal à 1.372), et l’augmentation des variances des estimateurs due à la colinéarité a pour effet de diminuer les t de Student, les rendant ainsi non significatifs.

III. Procédure de simulation et applications.

3.1 Démarche

On peut, par simulation, visualiser de façon plus complète l’effet de la colinéarité sur les coefficients de régression. La démarche est la suivante :

1) on choisit le nombre de variables explicatives p, le vecteur de régression théorique b = (b1, b2, …, bp)t, le coefficient constant b0, le coefficient de détermination R2 et le nombre d’observations n.

2) on choisit la matrice de corrélation R entre les variables explicatives ;

3) on simule un échantillon des variables explicatives xi,j de matrice de corrélation égale à R : le tableau X est alors fixé. Le modèle est complètement précisé et est égal à :

Y = b0 + b1 X1

+ b2

X2 + …+ bp Xp + e

4) la variance résiduelle s 2 est fixée à 1, et on choisit le coefficient de détermination R2.

5) on simule un échantillon indépendant de la v.a. e suivant la loi normale N(0,s), et on en déduit les valeurs simulées yi, i = 1, …n de la variable Y pour les valeurs xi,j du tableau X précédent.

6) on calcule le vecteur de régression estimé b = (b1, b2, …, bp) t.

7) on recommence la simulation effectuée en 5) pour obtenir un autre vecteur de régression, etc.

Chaque échantillon de la variable expliquée donne une estimation b du vecteur de régression b pour les mêmes valeurs des variables explicatives. On en déduit le carré de la distance ÷ïb - b÷ï 2. En répétant m fois cette opération, on dispose donc d’un échantillon de m vecteurs bl, l = 1,…m. On peut calculer le carré des distances dl 2 = ÷ïbl - b÷ï 2 des vecteurs estimés bl au vecteur théorique b en choisissant comme estimateur l’estimateur de la régression bornée Br pour différentes valeurs de k (pour k = 0, l’estimateur de la régression bornée est confondu avec l’estimateur des moindres carrés ordinaires).

3.2 Exemple.

Dans l’exemple ci-dessous, la matrice de corrélation R entre les variables explicatives est donnée dans le tableau 1. Les coefficients de régression et la constante choisis sont les suivants :

|

b0

= 0 |

b1

= 0.5 |

b2

= 0.5 |

b3

= -0.5 |

b4

= -0.5 |

Le modèle théorique est donc égal à :

Y =

0.5 X1 + 0.5 X2 – 0.5 X3 – 0.5 X4 +

e

La variable e figurant dans cette équation suit la loi normale. La variance résiduelle s 2 est égale à 1, et le coefficient R2 est fixé à 0.5. Pour obtenir un échantillon de la v.a. Y, il suffit de générer un échantillon indépendant ei, i = 1, …n de la loi normale N(0, s). On a alors : :

yi = 0.5 xi,1

+ 0.5 xi,2 – 0.5 xi,3 – 0.5 xi,4 + eI

On effectue ensuite la régression linéaire bornée. Le coefficient constant estimé b0 n’est pas nécessairement nul, mais n’est pas pris en compte dans le calcul des distances entre les vecteurs de régression. La taille de l’échantillon étant fixée à n = 100, nous donnons ci-dessous quelques résultats :

|

Coefficients théoriques |

0.5 |

0.5 |

-0.5 |

-0.5 |

Carré de la distance |

|

Coefficients estimés |

br1 |

br2 |

br3 |

br4 |

d

2 |

|

k = 0

(MCO) |

0.123 |

0.850 |

-0.445 |

-0.826 |

0.374 |

|

k =

0.01 |

0.356 |

0.688 |

-0.539 |

-0.611 |

0.070 |

|

k = 0.05 |

0.452 |

0.575 |

-0.543 |

-0.498 |

0.010 |

Tableau 9 : coefficients de régression estimés pour

différentes valeurs de k

En dernière colonne : carré de la distance au vecteur de

régression théorique

Le tableau précédent montre que l’estimation donnée pour k = 0.05 est nettement meilleure que les autres, et que l’estimateur des moindres carrés ordinaires, pour k = 0, est le moins bon.

3.3 Généralisation

Pour généraliser ces résultats, nous avons généré, pour les mêmes valeurs xi,j des variables explicatives (ou la même matrice de corrélation R entre les variables explicatives), cinquante échantillons de la v.a. Y, puis, pour chaque valeur de k, effectué les cinquante régressions et calculé les carrés dl 2 des distances, leur moyenne et leur variance :

|

k |

moyenne |

variance |

|

0 |

1.383 |

4.005 |

|

0.01 |

0.242 |

0.107 |

|

0.05 |

0.045 |

0.002 |

Tableau 10 : moyennes et variances des carrés des

distances d 2

pour k = 0, 0.01 et 0.05 (m = 50)

Le tableau précédent indique clairement que la régression classique donne des estimations beaucoup plus éloignées en moyenne des coefficients de régression théoriques que la régression bornée. La variance des carrés des distances est très élevée par rapport aux autres variances, et le meilleur estimateur des trois précédents est celui de la régression bornée pour k = 0.05.

Figure

2 : fonction de répartition des carrés des distances

(régression

des moindres carrés ordinaires, échantillon simulé de 50 termes)

La fonction de répartition des carrés des distances du vecteur de régression observé par le critère des moindres carrés ordinaires au vecteur de régression théorique est donnée en figure 2 ci-dessus. Elle met en évidence l’existence de modèles de régression obtenus par les moindres carrés ordinaires très différents du vecteur théorique. La valeur maximale des carrés des distances calculées sur les cinquante échantillons en posant k = 0.05 est égale à 0.208 : dans plus de 60% des cas, la régression des moindres carrés ordinaires donne un estimateur plus différent du vecteur théorique que le plus mauvais donné par la régression bornée.

Le tableau ci-dessous contient les dix vecteurs de régression obtenus par les moindres carrés ordinaires les plus éloignés du vecteur théorique :

|

|

R2 |

b0 |

b1 |

b2 |

b3 |

b4 |

d2 |

|

valeurs théoriques |

0.500 |

0.000 |

0.500 |

0.500 |

–0.500 |

–0.500 |

|

|

n° 50 |

0.597 |

-0.105 |

-0.444 |

1.135 |

-0.041 |

-1.495 |

2.494 |

|

n° 5 |

0.416 |

-0.231 |

-0.643 |

1.089 |

0.190 |

-1.413 |

2.963 |

|

n° 44 |

0.534 |

-0.020 |

-0.611 |

1.166 |

0.010 |

-1.690 |

3.353 |

|

n° 32 |

0.402 |

0.095 |

-0.841 |

1.248 |

-0.042 |

-1.413 |

3.400 |

|

n° 46 |

0.594 |

-0.081 |

-0.667 |

1.348 |

-0.045 |

-1.728 |

3.795 |

|

n° 47 |

0.424 |

0.117 |

1.693 |

-0.341 |

-1.118 |

0.714 |

3.986 |

|

n° 25 |

0.560 |

0.189 |

1.898 |

-0.336 |

-1.233 |

0.828 |

4.956 |

|

n° 42 |

0.589 |

0.071 |

-1.028 |

1.488 |

0.008 |

-1.910 |

5.556 |

|

n° 40 |

0.626 |

0.110 |

2.474 |

-0.642 |

-1.421 |

1.097 |

8.600 |

|

n° 23 |

0.407 |

0.119 |

-1.523 |

1.488 |

0.448 |

-2.124 |

8.605 |

Tableau 11 : les dix vecteurs de régression les plus

éloignés du vecteur théorique

(régression des moindres carrés ordinaires)

Le coefficient de détermination R2 et le coefficient constant b0 sont à peu près correctement estimés. Ce n’est pas le cas des coefficients de régression, très mal reconstruits. Dans tous les vecteurs de régression estimés, un au moins des coefficients est de signe contraire au coefficient théorique et certains autres sont très élevés en valeur absolue. Dans la pratique, le risque d’obtenir ce genre de résultats est loin d’être négligeable, puisque ces échantillons représentent 20% du nombre total d’échantillons.

Le vecteur de régression estimé dont la distance au vecteur théorique est approximativement égale à la distance moyenne égale à 1.383 n’est pas plus satisfaisant :

|

|

R2 |

b0 |

b1 |

b2 |

b3 |

b4 |

d2 |

|

n° 2 |

0.659 |

0.012 |

-0.173 |

0.927 |

-0.112 |

-1.179 |

1.247 |

Tableau 12 : vecteur de régression à une distance

moyenne du vecteur théorique

(régression des moindres carrés ordinaires)

L’idée qui vient naturellement est de déterminer sur ces cinquante échantillons la valeur de k qui donne les meilleurs résultats. En faisant varier k dans l’intervalle [0, 1] avec un incrément de 0.001, on obtient k = 0.078 :

|

k

|

moyenne

|

variance |

|

0.078 |

0.039 |

0.001 |

Tableau 13 : moyenne et variance des carrés des distances

dk 2

pour la valeur optimale k = 0.078 (m = 50)

La moyenne des carrés des distances est très faible par rapport à celle que l’on obtient par les estimateurs des moindres carrés ordinaires (0.039 au lieu de 1.383), et ces distances varient beaucoup moins : l’intérêt de la régression bornée est évident et considérable.

La simulation montre aussi la robustesse de la méthode : la moyenne des carrés des distances diminue très rapidement lorsque k varie de 0 à 0.05, reste à peu près constante lorsque k varie de 0.05 à 0.1 environ, et augmente ensuite lentement à partir de 0.1 (cf. figure 3 ci-dessous). La variance des distances, minimale aussi pour k = 0.078, suit la même évolution. La recherche précise de la meilleure valeur de la constante k ne présente visiblement guère d’intérêt.

Nous avons procédé à plusieurs simulations identiques : les résultats ont toujours été analogues aux précédents.

Figure 3

: moyenne des carrés des distances

entre

le vecteur théorique et le vecteur estimé en fonction de k

IV. Applications.

Dans le cas de données réelles quelconques, on ne connaît ni le vecteur de régression théorique b, ni la valeur optimale de la constante k. Pour choisir k , on utilise les ridge traces : l’absence de colinéarité se traduisant par une ridge trace très régulière, on va choisir comme valeur celle pour laquelle les coefficients de régression sont stabilisés.

4.1 Régression bornée en l’absence de colinéarité (données ridge0).

Effectuons d’abord la régression bornée dans le cas où les variables explicatives ne sont pas colinéaires. Les données analysées ci-dessous (fichier ridge0) ont été obtenues par simulation en supposant que les variables explicatives sont non corrélées. Les coefficients de régression et le coefficient de détermination théoriques sont les mêmes que ceux choisis précédemment pour créer les données ridge1 et ridge2.

Figure

4 : ridge trace (données ridge0)

La figure 4 ci-dessus est la ridge trace obtenue en effectuant les régressions bornées pour des valeurs de k variant de 0 à 1. On observe une très grande stabilité des coefficients de régression par rapport à la constante k. Le choix de cette dernière n’intervient guère dans les estimations.

4.2 Régression bornée des données ridge1.

Revenons au données traitées dans le paragraphe 2.1. La figure 5 ci-dessous donne la représentation graphique des estimations b1, b2, b3 et b4 des coefficients de régression suivant les valeurs de k. Pour k = 0, ces valeurs sont celles que l’on obtient par la régression des moindres carrés ordinaires.

On observe l’instabilité de ces coefficients pour les faibles valeurs de k. Les coefficients de régression b1 et b3 diminuent très rapidement en valeur absolue, au contraire de b2 et b4.

Figure

5 : ridge trace (données ridge1)

On recherche sur ce graphique une valeur de k pour laquelle les coefficients de régression sont stabilisés : on peut prendre ici k = 0.1. La régression bornée donne alors les résultats suivants :

|

|

br1 |

br2 |

br3 |

br4 |

Cst |

|

Estimation |

0.585141 |

0.405312 |

-0.480752 |

-0.426282 |

-0.164952 |

|

écart-type |

0.05550 |

0.06988 |

0.07351 |

0.05690 |

|

|

t

de Student |

6.955 |

3.826 |

-4.315 |

-4.943 |

|

Tableau

15 : résultats de la régression bornée (données ridge1, k = 0.1)

Le biais de l’estimateur Br apparaît dans le coefficient de corrélation non nul entre les résidus et la variable expliquée estimée par le modèle : r = 0.088. Les écarts-types indiquent une très grande stabilité de Br autour de son espérance E(Br), et les t de Student montrent que tous les coefficients sont significatifs.

Les simulations précédentes montrent que les coefficients obtenus sont largement plus proches des vraies valeurs que les estimations données par le critère des moindres carrés ordinaires.

4.2 Régression bornée des données ridge2.

La ridge trace (figure 6) montre une bonne stabilité des coefficients de régression, et les effets de la colinéarité concernent donc surtout les variances des estimateurs.

Figure

6 : ridge trace (données ridge2)

On peut le vérifier en choisissant une petite valeur de k, par exemple, k = 0.01 ou k = 0.02. Les résultats pour chacune de ces deux valeurs sont données dans les tableaux ci-dessous :

|

|

br1 |

br2 |

br3 |

br4 |

Cst |

|

Estimation |

0.468614 |

0.353795 |

-0.514348 |

-0.547913 |

-0.098518 |

|

écart-type |

0.23287 |

0.16324 |

0.13169 |

0.21075 |

|

|

t

de Student |

1.467 |

1.580 |

-2.848 |

-1.895 |

|

Tableau

16 : résultats de la régression bornée pour k = 0.01 (données ridge2)

|

|

br1 |

br2 |

br3 |

br4 |

Cst |

|

Estimation |

0.466987 |

0.344683 |

-0.505688 |

-0.542312 |

-0.098518 |

|

écart-type |

0.14950 |

0.11658 |

0.10273 |

0.13704 |

|

|

t

de Student |

2.277 |

2.156 |

-3.589 |

-2.885 |

|

Tableau

17 : résultats de la régression bornée pour k = 0.02 (données ridge2)

Il y a très peu de différences entre les estimations suivant les valeurs de k, mais les valeurs sont bien plus stables pour k = 0.02. La colinéarité entre les variables explicatives exerce ici un effet sur les variances, et les estimations obtenues suivant le critère des moindres carrés ordinaires sont beaucoup plus proches des valeurs théoriques que les écarts-types des estimateurs ne l’indiquent.

IV. Conclusion

Les coefficients de régression théoriques de ces applications sont en réalité connus : le modèle utilisé pour créer les données ridge1 et ridge2 est celui qui a été précisé dans le paragraphe 3.2. Le coefficient de détermination est fixé à 0.5, et les coefficients de régression théoriques sont :

|

b0

= 0 |

b1

= 0.5 |

b2

= 0.5 |

b3

= -0.5 |

b4

= -0.5 |

Les estimations obtenues dans le premier cas (données ridge1) sont beaucoup plus proches des valeurs théoriques que celles qui sont déduites du critère des moindres carrés ordinaires. Dans le second (données ridge2), elles sont beaucoup plus stables. Compte tenu des résultats des simulations donnés dans le paragraphe 3, on pouvait s’y attendre.

L’intérêt de la régression bornée apparaît finalement sur trois points :

1) lorsque les coefficients estimés par le critère des moindres carrés ordinaires sont très différents des vraies valeurs, elle donne des estimations bien meilleures ;

2) elle permet de contrôler la stabilité des estimations.

3) lorsque les variables explicatives sont non corrélées, elle ne modifie quasiment pas les estimations.

La stabilité des résultats par rapport à la valeur de la constante k limite l’importance de déterminer la meilleure valeur : une approximation même grossière, déduite simplement de la ridge trace, donnera des résultats en moyenne bien meilleurs que la régression des moindres carrés ordinaires. Par suite, en effectuant systématiquement une régression bornée pour une faible valeur de la constante k (par exemple k= 0.01) , les estimations des coefficients de régression ne peuvent être que meilleures, même lorsque la colinéarité entre les variables explicatives n’est pas très forte.

Ces simulations montrent le danger d’interpréter le signe des coefficients de régression sans précaution. Même lorsque toutes les hypothèses mathématiques sont satisfaites (distribution gaussienne de la variable résiduelle, linéarité des liaisons) – ce qui est le cas dans les exemples donnés puisqu’ils sont construits à partir de ces hypothèses –, il est très possible d’obtenir des résultats significatifs qui ne correspondent pas aux valeurs théoriques. Lorsque ces hypothèses ne sont qu’approximativement vérifiées, ce qui est le cas général des données réelles, la statistique produit des résultats qu’il est indispensable d’examiner avec prudence et de ne pas prendre pour certains même s’ils sont largement significatifs.

On a pu constater l’efficacité de la régression bornée dans les exemples donnés précédemment. Il est très vraisemblable qu’un estimateur borné donnerait aussi de bien meilleurs résultats en analyse factorielle discriminante et dans les méthodes de scoring fondées sur une inversion de matrice, toutes fréquemment utilisées dans les analyses de données d’assurances. Cette adaptation reste à faire semble-t-il.

Bibliographie :

Belsley D.A., Kuh E., Welsh R.E.

(1980): Regression diagnostics: identifying influential data and sources of

collinearity. Wiley, New York.

Foucart T. (1997): Numerical Analysis of a Correlation Matrix. Statistics, 29/4, p. 347-361.

Foucart

T. (2000): Colinéarité et Instabilité Numérique dans le Modèle Linéaire, RAIRO

Operations research, Vol.34, 2, p. 199-212.

Hoerl A.E., R.W. Kennard (19701): Ridge regression : biased

estimation for nonorthogonal problems. Technometrics, 12, 55-67.

Hoerl A.E., R.W. Kennard (1970 2): Ridge regression : Applications to nonorthogonal problems. Technometrics, 12, 69-82.

Tomassone R., Lesquoy E. et Millier C. (1992): La régression. Nouveaux regards sur une ancienne méthode statistique, Masson, Paris, 2e ed. .